W erze szybkiego rozwoju sztucznej inteligencji, narzędzia takie jak ChatGPT stają się coraz powszechniejsze w środowisku biznesowym. Jednak wraz z rosnącym wykorzystaniem AI, pojawiają się nowe wyzwania związane z dokładnością i wiarygodnością generowanych treści. Najnowsze badanie przeprowadzone przez zespół z MIT Sloan Management Review rzuca nowe światło na to, jak możemy poprawić jakość pracy z generatywną AI, jednocześnie zachowując efektywność.

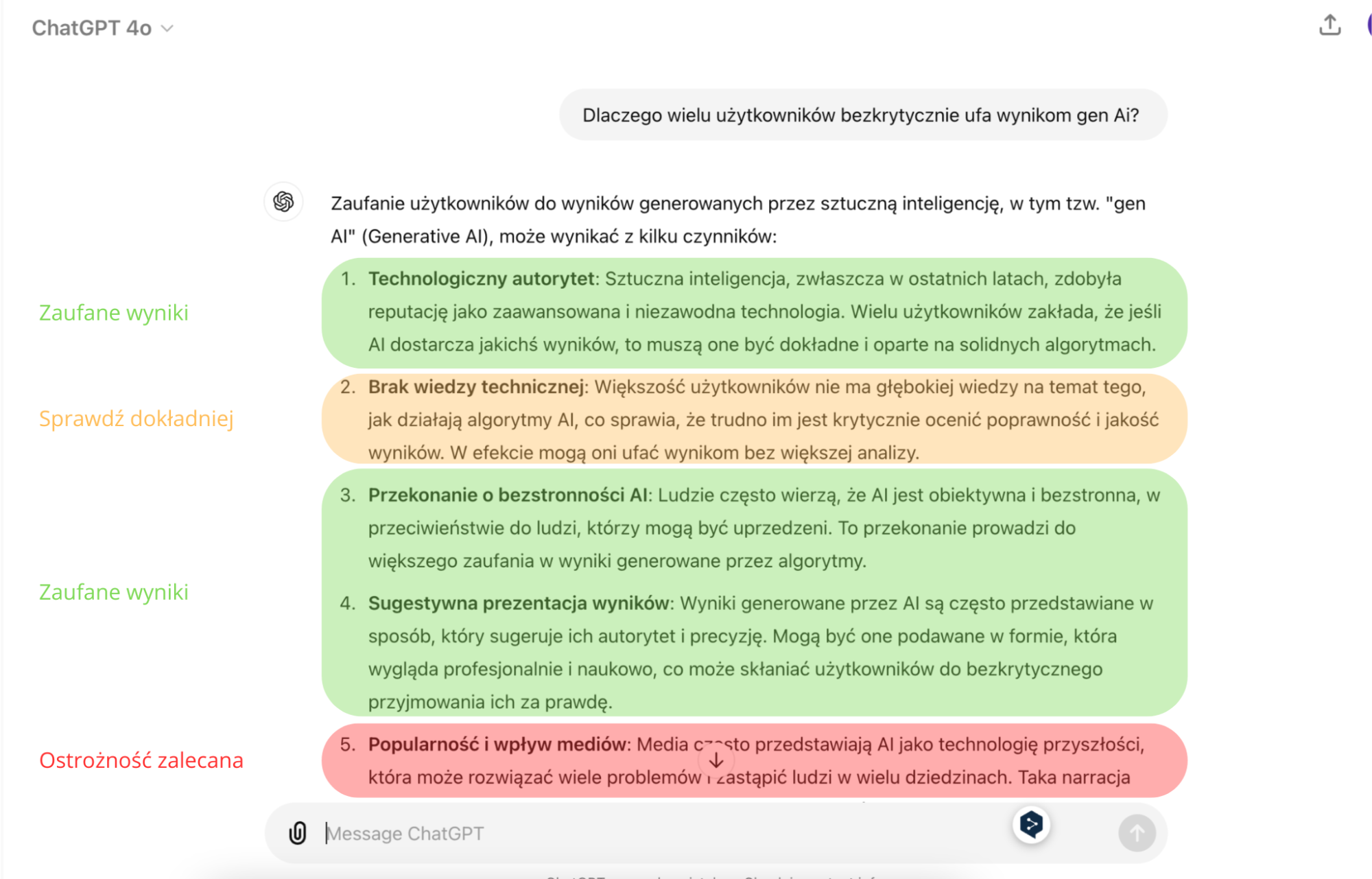

Problem: Bezkrytyczne przyjmowanie treści AI

Badacze z MIT zidentyfikowali kluczowy problem: użytkownicy mają tendencję do bezkrytycznego akceptowania treści generowanych przez AI. W przeprowadzonym eksperymencie odkryto, że finalne teksty uczestników były w 60-80% identyczne z wyjściem AI. To zjawisko, znane jako „efekt zakotwiczenia”, pokazuje, jak łatwo polegamy na sugestiach AI, często bez odpowiedniej weryfikacji.

Metodologia eksperymentu

Aby zbadać ten problem i znaleźć potencjalne rozwiązania, zespół MIT we współpracy z Accenture przeprowadził eksperyment. Oto kluczowe elementy metodologii:

- Uczestnicy: Profesjonaliści z dziedziny badań biznesowych w Accenture.

- Zadanie: Uczestnicy mieli za zadanie przygotować dwa streszczenia profili firm

- Narzędzie: Wykorzystano treści wygenerowane przez ChatGPT jako punkt wyjścia.

- Grupy eksperymentalne:

- Grupa kontrolna: bez dodatkowych dodatkowych narzędzi

- Grupa z pełnym podświetlaniem potencjalnych błędów, pominięcia, poprawne odpowiedzi

- Grupa z częściowym podświetlaniem: tylko potencjalne błędy i pominięcia były podświetlone

Projekt wizualizacji eksperymentu

Źródło: Opracowanie własne

Kluczowe wyniki

Eksperyment przyniósł kilka istotnych wniosków:

- Uczestnicy w grupach z podświetlaniem wykryli o 31% (zadanie 1) i 10% (zadanie 2) więcej błędów niż grupa kontrolna.

- Odsetek wykrytych pominięć wzrósł z 17% w grupie kontrolnej do 48% w grupie z pełnym podświetlaniem i 54% w grupie z częściowym podświetlaniem.

- Grupa pracująca z pełnym podświetlanie potrzebowała więcej czasu na wykonanie zadań (43% w zadaniu 1 i 61% w zadaniu 2.)

- Grupa z częściowym podświetlaniem osiągnęła najlepszy kompromis między poprawą dokładności a zachowaniem efektywności czasowej.

- Wprowadzenie mechanizmów podświetlania nie wpłynęło negatywnie na zaufanie użytkowników do narzędzi AI ani na ich chęć do korzystania z nich.

Implikacje wyników badania

Wyniki tego badania mają istotne implikacje dla organizacji korzystających z generatywnej AI:

- Konieczność świadomego podejścia: Organizacje powinny promować krytyczne myślenie i świadome korzystanie z narzędzi AI wśród swoich pracowników.

- Wdrożenie narzędzi wspomagających: Implementacja systemów podświetlających potencjalne błędy może znacząco poprawić jakość pracy z AI bez istotnego wpływu na efektywność.

- Balans między dokładnością a efektywnością: Organizacje mogą rozważyć wdrożenie częściowego podświetlania jako optymalnego rozwiązania, łączącego poprawę dokładności z zachowaniem wydajności.

- Szkolenia i rozwój: Konieczne jest edukowanie pracowników na temat ograniczeń AI i technik efektywnej weryfikacji generowanych treści.

- Ciągłe eksperymentowanie: Organizacje powinny prowadzić własne eksperymenty, aby znaleźć optymalne rozwiązania dostosowane do specyfiki ich branży i zadań.

Wnioski i przyszłe kierunki

Badanie MIT pokazuje, że możliwe jest znaczące poprawienie jakości pracy z generatywną AI poprzez wprowadzenie celowych „utrudnień” w procesie. Kluczowe jest znalezienie równowagi między dokładnością a efektywnością.

Przyszłe badania mogłyby skupić się na:

- Długoterminowych efektach stosowania takich narzędzi

- Adaptacji podobnych rozwiązań do różnych branż i typów zadań

- Rozwoju zaawansowanych algorytmów automatycznie identyfikujących potencjalne błędy w treściach generowanych przez AI

Generatywna AI oferuje ogromne możliwości, ale tylko świadome i odpowiedzialne jej wykorzystanie pozwoli w pełni wykorzystać jej potencjał przy jednoczesnym minimalizowaniu ryzyka błędów i niedokładności.

Źródło: MIT Sloan Management Review, Summer 2024 Autorzy badania: Renée Richardson Gosline, Yunhao Zhang, Haiwen Li, Paul Daugherty, Arnab D. Chakraborty, Philippe Roussiere, Patrick Connolly